gpt4all 사용

환경

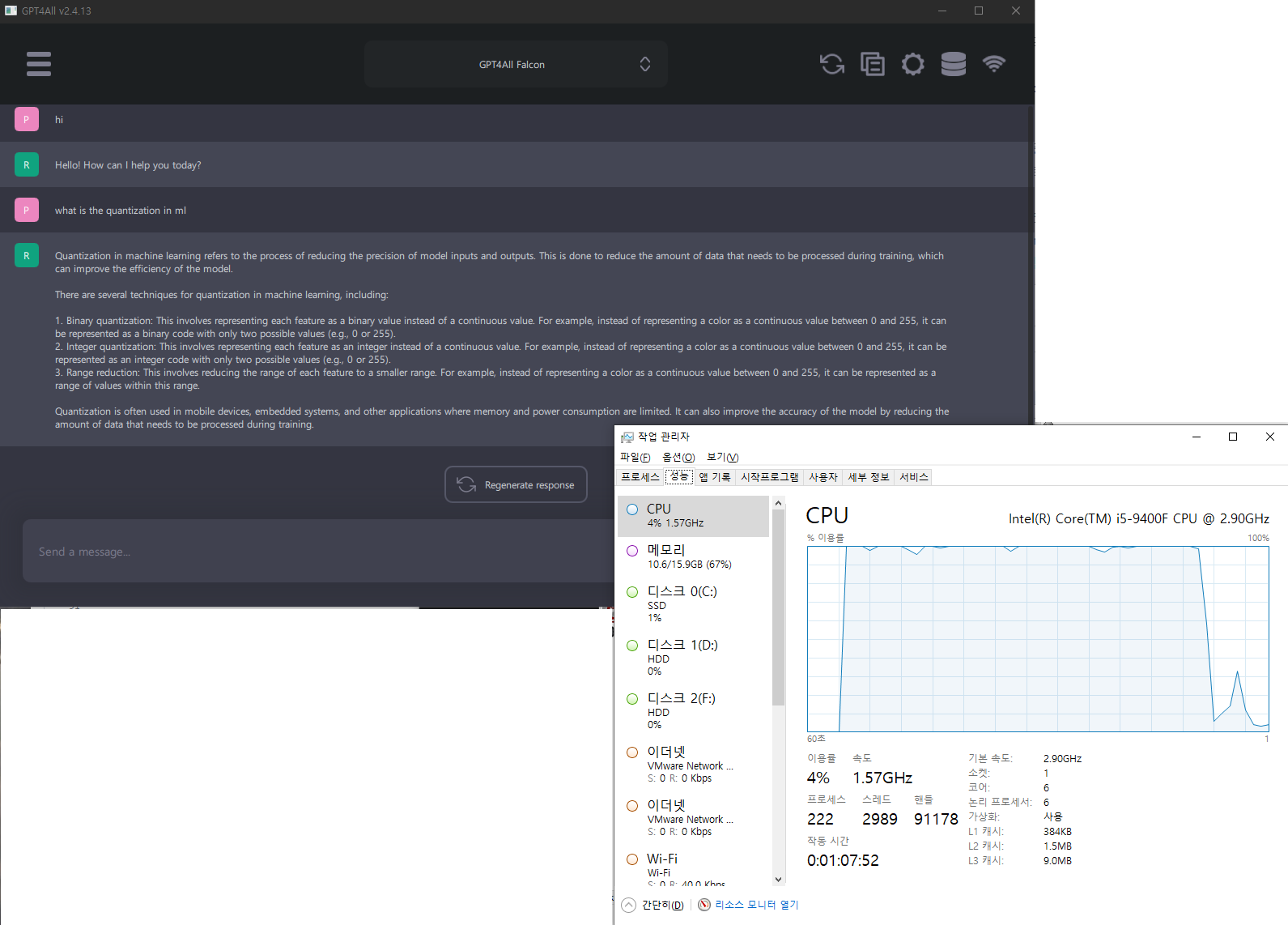

- windows10

- ram 16GB

- intel(R) core i5-9400F CPU@2.90GHz

GPT4All

- Nomic AI 에서 만들었다.

- 이 프로그램은 LLM 을 이용해서 chat 을 할 수 있도록 해주는 client 이다. 그래서 LLM 을 가지고 있진 않다. 설치후 다운로드 받아서 사용하도록 되어 있다.

- https://github.com/nomic-ai/gpt4all : 이 applicaiton 을 직접 build 도 할 수 있다.

- local cpu 에서 돌아가도록 되어있다. 그래서 CPU는 AVX 또는 AVX2 instruction 을 지원해야 한다. 대략 2011년 3Q 이후에 나온 cpu 면 다 지원되는듯(참고: https://en.wikipedia.org/wiki/Advanced_Vector_Extensions)

사용해보기

설치 파일(gpt4all-installer-win64.exe)을 받고 실행하면 된다. (여기로 가면 된다.)

설치하고 설치된 folder에 가서 다음 exe를 실행하면 된다.

d:\a\apps\gpt4all\bin\chat.exe을 실행하면 아래창이 뜬다.

모델을 선택하라는 화면, download 하길 모델을 선택한다. 그림에도 있지만, Wizard v1.1 의 경우 최소 16GB 이상의 RAM 이 필요하다고 나온다. 여기서는 좀 더 가벼운 GPT4All Falcon 을 택한다.

GPT4All Falcon

- download size : 3.78GB

- RAM required : 8GB

- parameters : 70억개

- Quantization: q4_0

cpu 사용률은 확실히 높다. 거의 100%를 다 사용한다. gpu 로 돌릴 수 있는 쪽이 사용하긴 더 좋을 듯 하다. 어느수준까지 질문을 해야할지는 모르겠지만 답변은 나쁘지 않아보인다. local에서 chatgpt 같은 수준의 LLM 을 돌릴려면 충분할 듯 싶기도 하다. 앞단에 서버만 하나 만들어주면, local chatGPT 도 가능할 듯.

댓글 없음:

댓글 쓰기